存储是机器学习的重要一环,因为训练模型意味着数百万甚至数十亿个文件必须尽可能快地被输送到配置了GPU的训练系统。

中存储网消息,存储是机器学习的重要一环,因为训练模型意味着数百万甚至数十亿个文件必须尽可能快地被输送到配置了GPU的训练系统。

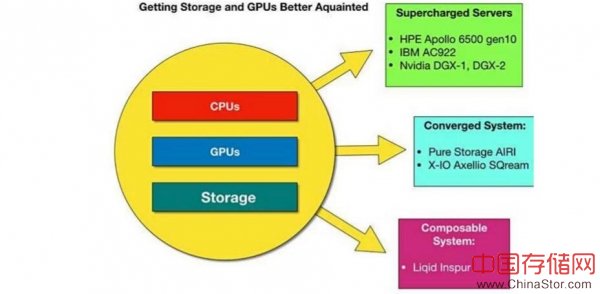

厂商们正在设计融合系统、超融合系统和可组合的系统来避开瓶颈,让机器学习客户更容易启动并运转起来。

最近我们看到Pure Storage和Nvidia推出了融合系统,Nvidia的AIRI系统采用4个Nvidia DGX-1 GPU增强型服务器来承载FlashBlade上存储的数据。

在这之前,还有HPE的Apollo 6500 Gen10和IBM的AC922服务器。

现在Nvidia已经发布了最新的DGX DGX-2。中国服务器厂商浪潮和可组合基础设施供应商Liqid已经为机器学习开发了Matrix Rack Composable平台,另外X-IO也将GPU和SQream数据库软件添加到Axellio组合服务器+存储系统中。

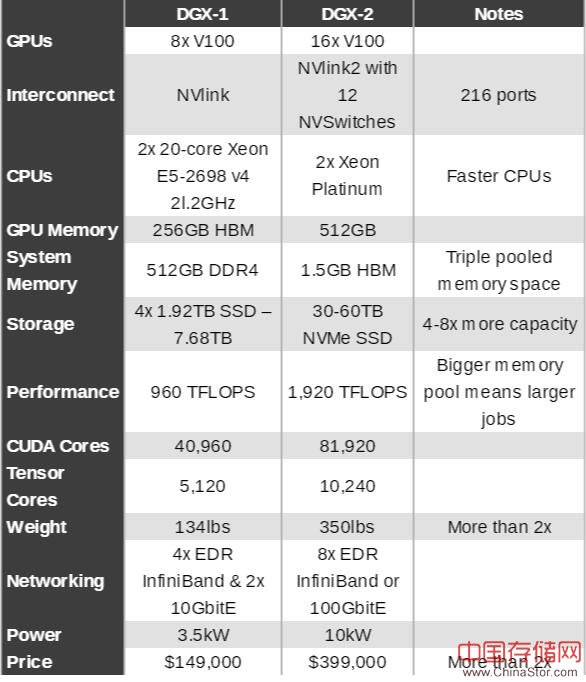

Nvidia DGX-2

DGX-2是2个DGX-1以及更多的CPU、内存、互联带宽和存储:

更大的系统内存,意味着更大型的任务可以运行在DGX-2中,因此完成速度将提高2倍。

DGX-2的发布日期与Pure-Nvidia AIRI系统非常接近,显然Pure和Nvidia决定不做基于DGX-2的AIRI。但是,未来AIRI系统有可能是基于DGX-2的,并且有更大的闪存驱动器,占用16个GPU。我们假设这是一个价值200多万美元的系统,这样潜在客户数量就更少了。

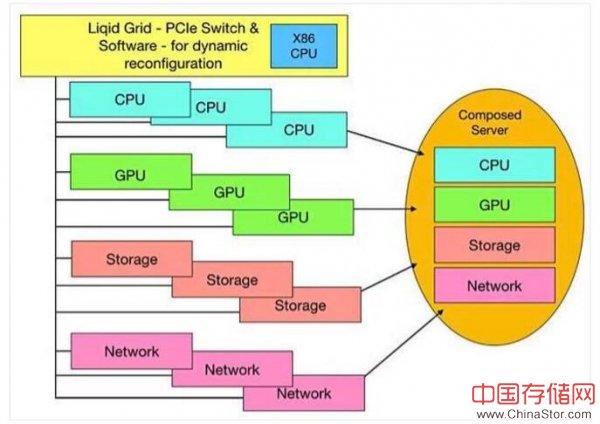

浪潮和Liqid

浪潮和Liqid联合开发了Matrix Rack Composable平台,让用户可以动态设置针对特定工作负载组成的CPU-GPU-存储组合。浪潮提供i24服务器和GX4机箱,Nvidia Tesla V100和P100 GPU,以及Liqid基于Grid PCIe的光纤硬件和软件。

一开始是一系列分散的计算、GPU、存储和以太网网络资源池,来自这些池的元素可以通过PCIe结构进行组合、集群、编排和共享。

池元素包含:

- 24个计算节点(双英特尔至强可扩展处理器)

- 144个U.2固态硬盘(SSD),每个固态硬盘6.4 TB(922TB)

- 24个网络适配器(NIC),双100 Gb/NIC

- 48个NVIDIA GPU(V100和P100)

- Liqid Grid(Managed PCIe Gen 3.0 Fabric)和Liqid Command Center(软件)

Liqid Grid PCIe光纤交换机

一个最大限度配置的系统可能会完败Pure-Nvidia AIRI系统,并且V100 GPU的数量 要比Nvidia自己的DGX-2多出3倍。这种完全配置的Matrix Rack的成本将是一个天文数字。

浪潮公司副总裁、总经理Dolly Wu向中存储网记者表示:“人工智能和深度学习应用将决定下一代基础设施设计的方向,我们相信动态组合的GPU将成为这些新兴平台的核心。”

我们未来可能会看到其他可组合式的服务器系统厂商也将GPU添加到他们的分解资源池中,例如Attala Systems、拥有Synergy的HPE、DriveScale、拥有RackScale的英特尔。

X-IO、SQream和Nvidia

回到现实中来,我们看到X-IO的Axellio边缘计算+存储产品增加了Nvidia GPU和SQream数据库软件,为“大规模数据集的极速数据分析”提供“融合设备”。

SQream对其DBMS软件所做的,是采取重复性的低级别SQL查询操作,并在服务器GPU加速器上运行这些操作。SQream向中存储网记者表示,复杂的查询涉及多个过滤器、类型转换、复杂谓词、异种连接语义和子查询。当这些数据运行在100TB的数据集上时,几个表中数十亿行可能需要几分钟到几小时才能完成(查询延迟)。

SQream向中存储网记者表示,它可以在柱状数据库集上让查询加速20倍,并且查询大型复杂数据的速度也要比其他关系数据库快100倍。据称,它对100TB数据集的复杂查询延迟在数秒到数分钟之间。其接收速度高达2TB/小时。

这可以大规模地减少在大型数据集上运行SQL查询所需的服务器;SQream声称,一台2U服务器加上GPU,相当于一台装满服务器的42U机架。SQream说,使用我们的关系数据库可以获得令人尖叫的SQL性能。

X-IO向中存储网记者表示,在我们的硬件上运行吧,可以更快。

服务器/存储方面,X-IO有Axellio Edge Micro-Datacenter设备产品,这个2U设备中包含了2个至强服务器模块,配置2个至强处理器,2个Tesla P100 GPU,1个PCIe光纤架构,1到6个FlashPac,每个FlashPac最多可配置12个双端口NVMe SSD(800、1600、3200或6400GB),最大容量为500TB。

SQream和X-IO向中存储网记者表示,他们组合式系统构成的双节点能够以每GPU最高3.2GB/秒的速度将数据从存储发送到GPU。在运行分析的时候,这个系统的速度可以达到11.5TB/小时。

这两家公司向中存储网记者表示,用户能够实时地对查询做出相应,而这在以前需要几分钟的时间,或者将他们的查询窗口从原来的数周甚至数年扩展到查找趋势,查询数万亿行数据并更快获得结果。

X-IO可能也在考虑涉足机器学习领域。从理论上讲,机器学习框架软件厂商要进入这个领域是很容易的。只是另一种伙伴关系,对吧。

前景看好

机器学习被视为一个热门的增长市场,将其与本地NVMe闪存存储和大数据分析应用相结合,就能打造出热门的产品。

估计Dell EMC和NetApp肯定也会进入采用GPU增强系统的市场,更不用说华为和联想了。其他全闪存阵列供应商可能会考虑类似Pure-Nvidia的合作方式,还有例如Kaminario、Tintri和WDC Tegile可能也会这么想。

非GPU系统的性能提升令人印象深刻,利润率可以设定得足以让销售人员垂涎。 这种GPU加速的服务器/存储产品开发空间将随着供应商的涌入而扩展,充分展现其增长的前景。

声明: 此文观点不代表本站立场;转载须要保留原文链接;版权疑问请联系我们。