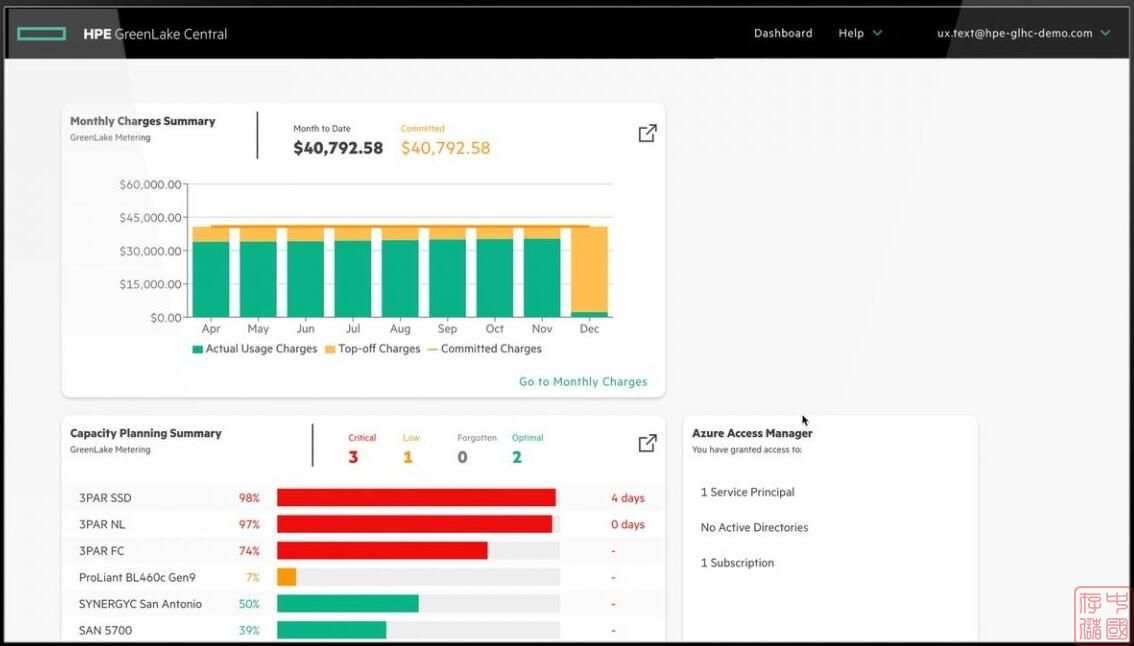

这些改进使 HPE 能够将 AI 规模的吞吐量提高两倍,并将功耗降低多达 50%。

2024 年 3 月 5 日 — HPE 今日宣布扩展 HPE GreenLake 文件存储功能,推出专为支持大型企业 AI 和数据湖工作负载而设计的全新高密度全闪存选项。与目前发布的 HPE GreenLake 文件存储版本相比,HPE 的新选件可提供 4 倍的容量和 2 倍的系统性能。

这些改进使 HPE 能够将 AI 规模的吞吐量提高两倍,并将功耗降低多达 50%。通过具有双倍处理能力和存储单元以及 1-RU 1.3560PB 全 NVMe JBOF 的新型控制器,HPE 客户现在可以加速工作负载、削减成本并大幅减少数据中心占用空间和功耗。

借助这些增强功能,慧与在帮助客户实现企业性能、简单性和提高效率方面又迈出了重要一步,所有这些都是在 AI 和数据湖规模上实现的。慧与正在帮助企业更好地发挥 AI 的强大功能,并从数据中释放更多价值。

借助慧与最新的高密度存储机架,HPE GreenLake 文件存储解决方案将高端产品的容量密度提高了 7 倍,是 2023 年年中发布的产品。此外,正如所承诺的那样,HPE GreenLake 文件存储解决方案现在提供的容量密度是 Dell PowerScale 和 Pure Storage FlashBlade 的 2.3 倍。

HPE 的公告进一步扩展了公司在 AI 和数据湖规模性能和容量方面的能力。它展示了慧与的持续承诺和发展轨迹,即始终领先于客户的要求,以保护和扩展他们在业界最全面的横向扩展文件数据解决方案方面的投资,以满足要求苛刻的 AI 和数据湖工作负载。

作为一家进入或扩展 AI 计划的企业,客户希望 IT 部门能够以 AI 规模提供企业绩效,从高效、高性能的数据聚合和准备能力开始,扩展到模型训练、调优和推理,以涵盖 AI 的所有阶段,从而加速数据最密集型的应用程序。

从 GenAI 和大型语言模型 (LLM) 到无数其他 AI 工作负载,HPE GreenLake 文件存储服务不仅能提供企业级性能,还能提供 AI 规模的简单性和更高的效率。

大规模性能限制可能是 AI 存储的一个问题,尤其是采用无共享架构的传统横向扩展 NAS 解决方案。这些解决方案可以扩展容量,但无法线性扩展性能以匹配该容量。

HPE GreenLake 文件存储解决方案可利用 AI 规模的企业级性能加速客户数据密集型应用。这是跨越 AI 所有阶段的性能——从数据聚合、数据准备、训练和调整到推理。对于小型数据集来说,不仅仅是性能在某个时间点达到峰值。相反,它是一种快速、持续的性能,可以跨越要求最苛刻的数据密集型 AI 应用程序的整个数据规模,包括 GenAI 和大型语言模型 (LLM)。

AI 规模的企业性能可帮助客户从所有聚合数据中释放更多价值,从而更快地获得见解,并提供实际的竞争优势。

HPE GreenLake 文件存储解决方案采用分解式、共享式、高弹性模块化架构,支持客户独立扩展性能和容量,专为 EB 级扩展而设计。凭借全 NVMe 速度实现快速、可预测的性能,并且无需前端缓存、介质之间的数据移动或分层数据管道,客户可以增强数据密集型 AI 应用程序的性能。

声明: 此文观点不代表本站立场;转载须要保留原文链接;版权疑问请联系我们。