AI 工作负载严重依赖内存带宽和容量,而美光已做好充分准备,HBM3E 和 HBM4 解决方案组合,支持未来 AI 的显著增长。

美光科技26日宣布已开始批量生产其 HBM3E(高带宽内存 3E)解决方案。美光的 24GB 8H HBM3E 将成为 NVIDIA H200 Tensor Core GPU 的一部分,该 GPU 将于 2024 年第二季度开始发货。

这一里程碑使美光处于行业的前沿,以 HBM3E 行业领先的性能和能效为人工智能 (AI) 解决方案提供支持。

HBM3E:推动人工智能革命

随着对 AI 的需求持续激增,对内存解决方案的需求与扩展的工作负载保持同步至关重要。美光的 HBM3E 解决方案通过以下方式直面这一挑战:

- 卓越的性能: 美光的 HBM3E 引脚速度大于 9.2 Gb/s,可提供超过 1.2 TB/s 的内存带宽,为 AI 加速器、超级计算机和数据中心提供闪电般的数据访问。

- 卓越的效率: 美光的 HBM3E 与竞争产品相比,功耗降低了 ~30%,处于行业领先地位。为了支持日益增长的 AI 需求和使用,HBM3E 以最低的功耗提供最大的吞吐量,以改善重要的数据中心运营费用指标。

- 无缝可扩展性: 美光的 HBM3E 目前拥有 24 GB 的容量,使数据中心能够无缝扩展其 AI 应用程序。无论是训练大规模神经网络还是加速推理任务,美光的解决方案都能提供必要的内存带宽。

美光科技执行副总裁兼首席商务官 Sumit Sadana 表示:“美光凭借这一 HBM3E 里程碑实现了三重奏:上市时间领先地位、一流的行业性能和差异化的能效特性。AI 工作负载严重依赖内存带宽和容量,而美光已做好充分准备,通过我们行业领先的 HBM3E 和 HBM4 路线图,以及我们面向 AI 应用的完整 DRAM 和 NAND 解决方案组合,支持未来 AI 的显著增长。

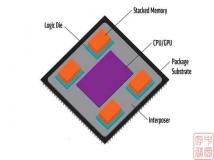

美光利用其 1-beta 技术、先进的硅通孔 (TSV) 和其他创新技术开发了这种行业领先的 HBM3E 设计,从而实现了差异化的封装解决方案。美光是 2.5D/3D 堆叠和先进封装技术内存领域公认的领导者,很荣幸成为台积电 3DFabric 联盟的合作伙伴,并帮助塑造半导体和系统创新的未来。

美光还通过 2024 年 3 月推出 36GB 12 高 HBM3E 样品来扩大其领导地位,与竞争解决方案相比,该产品将提供超过 1.2 TB/s 的性能和卓越的能效。美光是 NVIDIA GTC 的赞助商,NVIDIA GTC 将于 3 月 18 日开始,该公司将在会上分享更多关于其行业领先的 AI 内存产品组合和路线图的信息。

声明: 此文观点不代表本站立场;转载须要保留原文链接;版权疑问请联系我们。