Brandwein说他们的长期的目标是,使Spark工作规模同时在多租户集群拥有超过10000个节点成为可能,这需要Spark的可靠性、稳定性和效率显著改善。

Apache Spark内存计算框架更接近于Apache Hadoop,Cloudera今天宣布它正努力地使Spark取代默认的Hadoop数据处理框架。

“虽然IT公司将会继续添加其他数据处理框架叠加在Hadoop集群顶部,One Platinum Initiativ是一个以Spark取代MapReduce作为默认数据处理引擎的基本案。”Cloudera的产品营销总监Matt Brandwein。

大多数IT组织认为MapReduce是一个相当晦涩难懂的编程工具。出于这个原因,许多人愿意采用任意数量的SQL引擎作为查询Hadoop数据的工具。

谷歌因为没有达到预期的目标,公开宣布停止使用MapReducebecause,取而代之的是自己公司Dataflow框架。公司launchedDataflow今年早些时候一个测试版的云服务。该公司今年早些时候推出了Dataflow作为测试云服务。

当涉及到建筑分析应用程序驻留在Hadoop上, Spark框架已经受到大量的拥护。

Brandwein指出, Spark的项目比Hadoop项目更活跃50%。One Platinum倡议会实际上形式化已经用标准方法迅速构建Hadoop上分析的应用程序。

“我们希望将Apache Spark和Hadoop统一起来。”他说。“我们已经有200多个客户运行Apache Hadoop的Spark。”

Cloudera声称Brandwein有比其他Hadoop供应商多五倍多的工程资源致力于Spark,并且贡献了超过370个补丁和43000行代码给开源流分析项目。Cloudera也促使Spark集成Hadoop上的资源整合,此外集成工作涉及的SQL框架如Impala;信息传递系统如Kafka;还有数据摄入工具,如Flume。

Brandwein说他们的长期的目标是,使Spark工作规模同时在多租户集群拥有超过10000个节点成为可能,这需要Spark的可靠性、稳定性和效率显著改善。

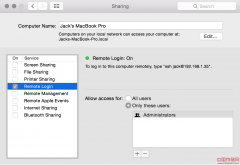

Cloudera补充说,它也致力于使Spark更容易在企业生产环境中管理,确保Spark流至少支持80%常见流处理的工作量。最后,要使.使这些实时工作量达到.更高水平的语言层次之外,Cloudera将提高Spark流的效率。

这一倡议到底得到多少支持Cloudera也有待观察。例如,该公司与Inte和Oracle有着长期的合作关系。在这个关头,其余的IT产业似乎更致力于Cloudera的竞争对手Hortonworks提出的Hadoop分配。

原文链接:Cloudera Aims to Replace MapReduce With Spark as Default Hadoop Framework

声明: 此文观点不代表本站立场;转载须要保留原文链接;版权疑问请联系我们。