本文对HDS存储产品的硬件和软件做了简单介绍,文字精炼,是快速入门HDS存储的好资料。

本文对HDS存储产品的硬件和软件做了简单介绍,文字精炼,是快速入门HDS存储的好资料。

专业术语

- Direct Attached Storage——直连存储

- Storage Area Network——存储区域网

- Network Attached Storage——网络附接存储

NAS实际上就是一个专门优化了的文件服务器,可分为:

- NAS整体系统:带有磁盘空间的NAS系统

- NAS Gateway:不带磁盘空间的NAS系统,但可以外接一个存储(DAS或者SAN)获得磁盘空间;

- NAS Blade:不带磁盘空间的NAS系统,且表现的形式为一个或一对卡、控制器模式,而必须插入存储系统,而获得电源和存储空间

SAN是由服务器中HBA卡、存储交换机以及存储系统构建而成的存储网络

- SAN的主要元素:HBA卡、存储交换机、存储子系统

随着技术演化,SAN现在分为:FC SAN(FC协议)、IP SAN(iSCSI协议)

HBA

- 提供服务器内部IO总线(PCI/SBUS) 与光纤网络的接口;

- HBA自身的RISC可以分担主机服务器CPU的IO管理工作;

- HBA有足够的缓存来存储IO的Context(最大2047个),以此来提高交叉存取的性能。否则经常要向服务器请求中断,这样就会影响系统性能,浪费许多CPU周期;

- 其Coalescing (聚集) 功能还可以通过并发处理节省IO的中断次数;

- HBA软件驱动为操作系统提供所须存储信息,对I/O进行操作,同时对正常请求进行控制

硬件

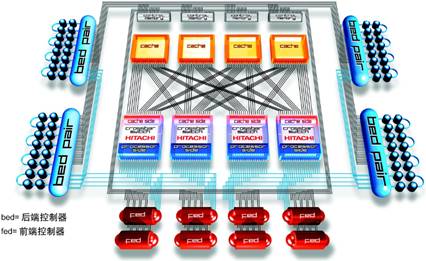

HDS USP V架构同样采用HDS久负盛名的高性能、无瓶颈的Universal Star Network全光纤交换结构(第代四Hi-Star架构)。该系统性能、扩展性等方面全面超越目前业界已有的高端存储系统,而且提供了全面的虚拟存储解决方案,使异构存储系统互联互通成为可能。

如图所示,在交换式架构中,最重要的部件是缓存交换模块(CSW)。通过CSW,主机接口控制器、数据Cache和磁盘通道控制器连接在一起,数据Cache与前后两端控制器之间都能够构成“点对点”的连接,实现并发通道数量最大,数据通道利用率最高。通过使用交换式的结构,使HDS USP V磁盘存储系统具有了良好的扩展能力,前端的主机通道控制器、后端磁盘通道控制器和Cache都能够在线的、灵活的进行升级,从而降低了系统升级的投资。

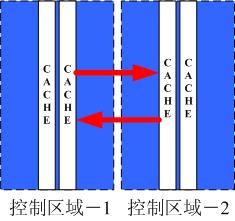

HDS USP V的Cache设计中采用了Cache写镜像技术,即将Cache板分别至于两个互为备份的控制区域内,在响应读操作时这两个控制区域中的Cache在是独立响应的;在进行写操作时,当数据写入任何一个控制区域中的Cache时,同时会在另外一个控制区域中的Cache中保留一份镜像数据,直到这些数据被写入硬盘。

HDS USP V磁盘存储系统为了有效的提高读Cache的效率和减少Cache中的寻址时间,将数据Cache和控制Cache分离开来,独自承担不同的任务。

数据Cache中包含应用系统的读、写数据;

控制Cache中包含数据在数据Cache中的位置信息、逻辑卷信息、配置信息等

控制Cache中的众多信息中,数据的Cache位置信息非常重要,主机通道控制器通过获取这些位置信息缩短在数据Cache中的寻址时间,提高了数据访问速度;另外,如果控制Cache中没有主机要访问的数据的位置信息时,就说明该数据并没有在数据Cache中,此时控制Cache将向磁盘通道控制器发送请求,将该数据从硬盘写入至Cache,并且更新控制Cache中的位置信息。如果没有控制Cache,所有的I/O操作请求都集中在Cache中处理,Cache越大,寻址时间越长,最终导致系统性能下将。

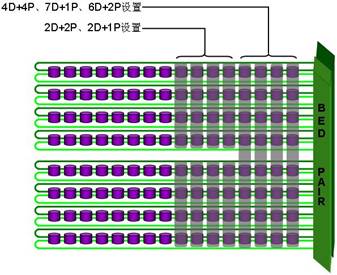

HDS USP V系列产品对RAID保护技术也进行的增强与灵活选择。在RAID 0+1保护方式下,一个RAID组可以由4块或8块物理盘组成2D+2D或4D+4D,这样可以达到更高的性能。同时HDS USP V还提供由4块或8块组成的物理盘支持RAID 5保护方式下的3D+1P、7D+1P,其中7D+1P的RAID 5 方式可以极大的提高磁盘组的利用率(87.5%),节约了盘组投资并可同时提高大文件处理方式的性能,6D+2P的RAID6方式主要是针对使用300GB硬盘,以提高300GB硬盘RAID组的数据安全性。

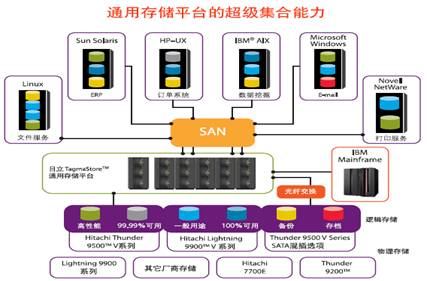

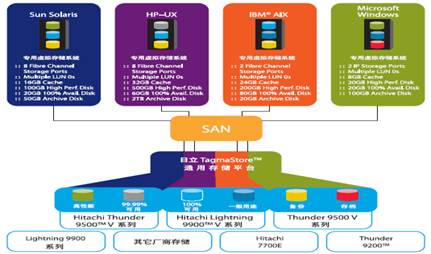

HDS USP V通用存储平台通过存储虚拟化的技术,可以实现将不同厂商的存储系统集合到同一个存储池中。HDS USP V存储平台内部的资源为内部存储资源,与之相连的其它存储设备上的资源是外部资源。通过该功能,可以使用统一的管理平台实现对内部和外部存储资源的统一管理,统一分配,可以按照应用系统的性能要求分配相应的存储资源。从主机的角度看,内部存储资源和外部存储资源功能完全相同,而内部和外部存储资源之间的数据交换可以通过存储系统本身的数据复制和数据迁移软件来完成。

HDS在通用存储平台上引入了逻辑分区的概念,这也是目前在存储系统中唯一的技术。通过这个技术,你可以对通用存储平台进行逻辑划分,最大可以32个逻辑虚拟存储系统。每个虚拟存储系统都拥有独立的主机通道端口、CACHE、磁盘等资源。在通用存储平台和与之相连的外部存储设备中,通过逻辑分区功能可以使得应用系统的需求和分配给该应用的资源得到合理的调度和匹配,从而保证应用服务质量。

软件

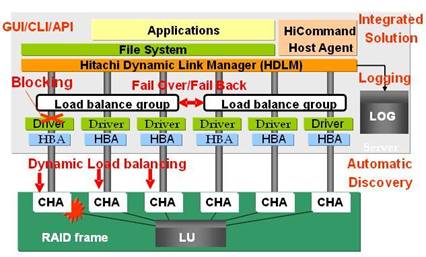

HDLM(Hitachi Dynamic Link Manager)是HDS公司提供的安装在主机端的存储工具软件。HDLM提供主机到存储系统的I/O通道负载平衡和故障切换功能;增强了主机系统的数据可得性。虽然存储系统通过RAID技术对数据进行了保护,但是单纯的存储系统是不能够提供整个I/O系统的端到端的保护的。主机端到存储系统的整个I/O路径中发生了故障如:HBA失效、FC交换设备故障、连接电缆断开等会中断主机端对数据的访问;HDS公司提供的HDLM软件,通过对主机到存储的冗余I/O路径的管理实现负载均和故障切换;保证了24?7业务不间断的运行。

HDLM对I/O通道进行实时控制,检测每个通道的状态;当有任何一个通道发生故障时自动将I/O切换到其它健康的通道上;同时,HDLM会自动记录整个操作过程。HDLM能够支持所有的HDS存储系统,并且在功能上基本相同。

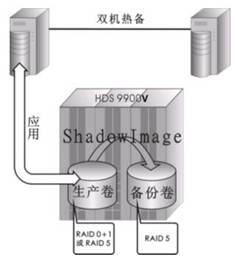

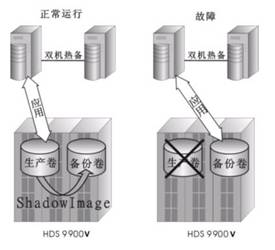

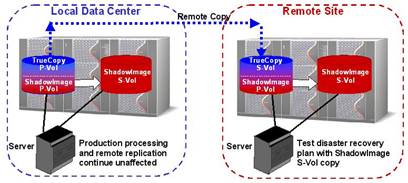

ShadowImage是HDS公司深入研究当今商业社会业务连续性处理流程、7 x 24 x 365服务、数据可靠性、数据可用性、数据保护等一系列需求后,全力开发的、业界公认的、技术领先的数据复制软件。基于存储系统内部运行的数据复制技术,无需主机资源参与,最大程度的发挥了软件的可用性;瞬间分离得到的多个数据备份拷贝,提供了用户并行处理联机业务、批量作业、应用开发、测试、数据分析和数据挖掘、快速恢复的解决方案,节约了生产主机宝贵的资源而处理其他重要的业务,革新了批量作业、磁带备份的新策略,给客户提供了最佳投资选择-最小的总拥有价值(TOC)和最大化的投资回报。配合HDS公司的Disaster Recovery和Freedom智能存储系统,为客户提供高度安全的、高度灵活的、高度统一的数据保护、容灾、数据备份的解决方案。

|

|

||

ShadowImage提供了全新的、经济的、可实施的容灾测试解决方案,可以在保持本地生产系统和远程拷贝不受影响的情况下,通过远程SI的PIT拷贝,进行实时的、模拟真实数据环境的灾难恢复计划的测试

Disaster Recovery数据远程容灾解决方案是HDS公司在全面分析各种操作系统、各种容灾技术、仔细研究客户对容灾的需求和理念之后,结合HDS USP V 智能存储系统的特点推出的数据远程容灾解决方案;彻底解决长期困绕用户的、难于进行容灾方案的真实演练、真实数据测试的问题,最大限度的减少数据丢失问题;Disaster Recovery是基于磁盘存储系统运行的软件包,不依赖任何的主机操作系统和其他第三方厂商软件,为用户提供了最安全、最开放、最经济、最实用的远程容灾解决方案。

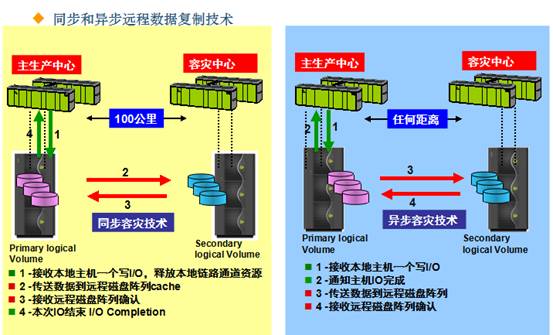

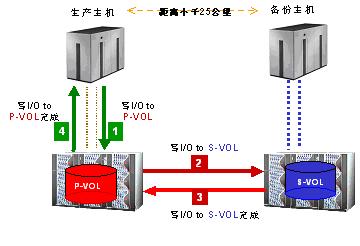

远程容灾同步方式数据备份:

远端的数据拷贝与本地的数据拷贝或生产数据永远保持一致,远端拷贝永远是本地数据盘的“镜像”,不会出现数据丢失。主机应用程序每次I/O将承受备份端存储系统I/O确认的延迟,以及由此带来的主机系统处理能力降低和资源消耗的冲击。受应用系统I/O读写的活动频率、网络带宽、可以容忍的交易响应时间和其他因素的影响,远程同步工作方式有距离的限制,一般小于25公里

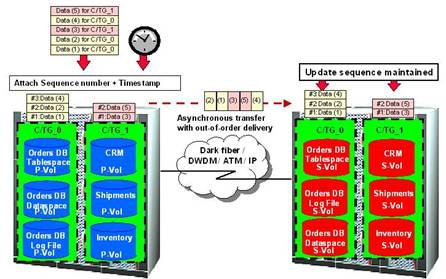

远程容灾异步方式数据备份:

由于I/O操作不是同步的传送到备份中心,在异步方式下,就存在数据的传送顺序与实际的数据的操作顺序不一致问题。为了解决这一问题,HDS容灾软件对每个写入生产中心存储系统的I/O都打上一个时间戳(TimeStamp)并进行一致性分组(Consistency Group), 在数据传输至备份中心时,备份中心存储系统严格按照此时间戳的时间顺序重新排列并写入相应的逻辑卷中,从而保证了备份数据的逻辑一致性与完整性。目前,HDS的Disaster Recovery软件其独有的时间戳(Timestamp)和一致性组(Consistency Group)技术,是目前存储业界唯一可行且安全的存储系统之间的异步数据备份方案并被广大用户采用。

Disaster Recovery+ShadowImage配合使用为用户提供了“终极”数据保护的解决方案,实现了多重媒介、多重备份、异地容灾、本地镜像、本地恢复、异地恢复的立体数据保护解决方案。

声明: 此文观点不代表本站立场;转载须要保留原文链接;版权疑问请联系我们。